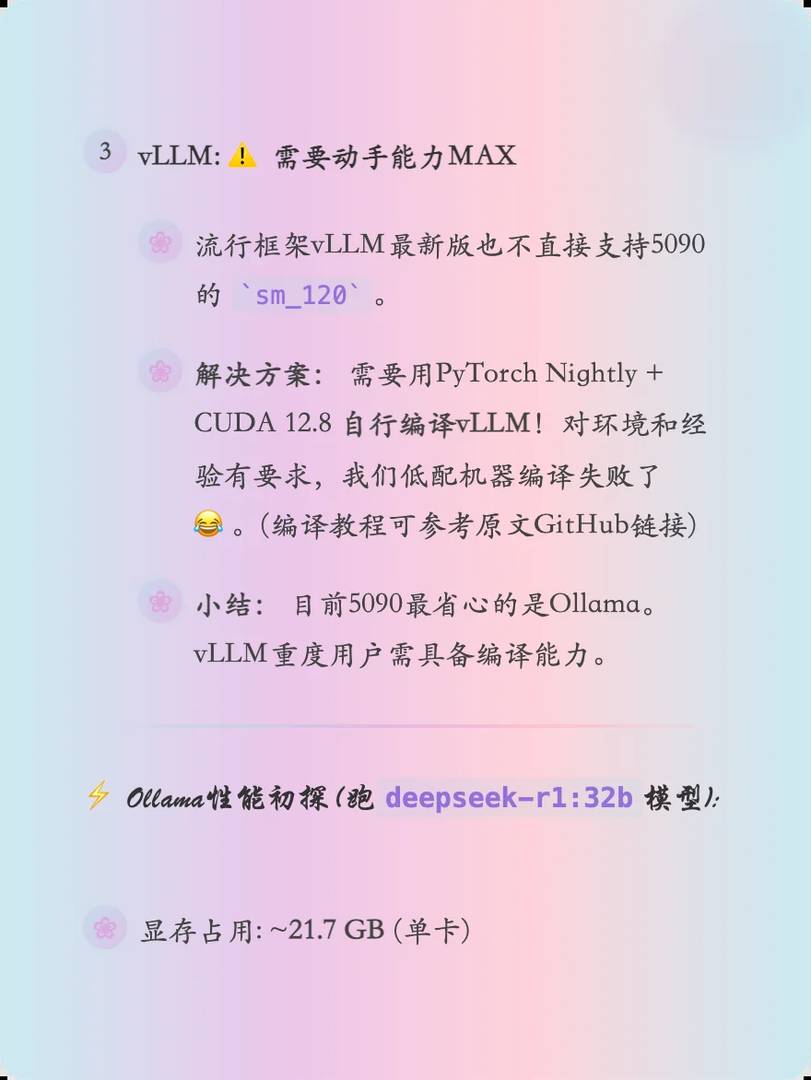

Benchmark de performances AI sur double GPU RTX 5090 : Cadres d'inférence ultimes et limites de vitesse testés

Salut, passionnés d'IA et pionniers de la technologie ! 🚀 J'ai juste déverrouillé la machine des rêves ultimes - un monstre de station de travail avec deux GPUs RTX 5090 ! Je n'ai pas pu attendre pour soumettre cette bête à des tests d'inférence IA de pointe sous Ubuntu. 🔥 Curieux de savoir comment se déroulent les affrontements entre cadres et de briser les records de performances ? Attachez-vous - ce post est votre billet d'or pour toutes les informations croustillantes !

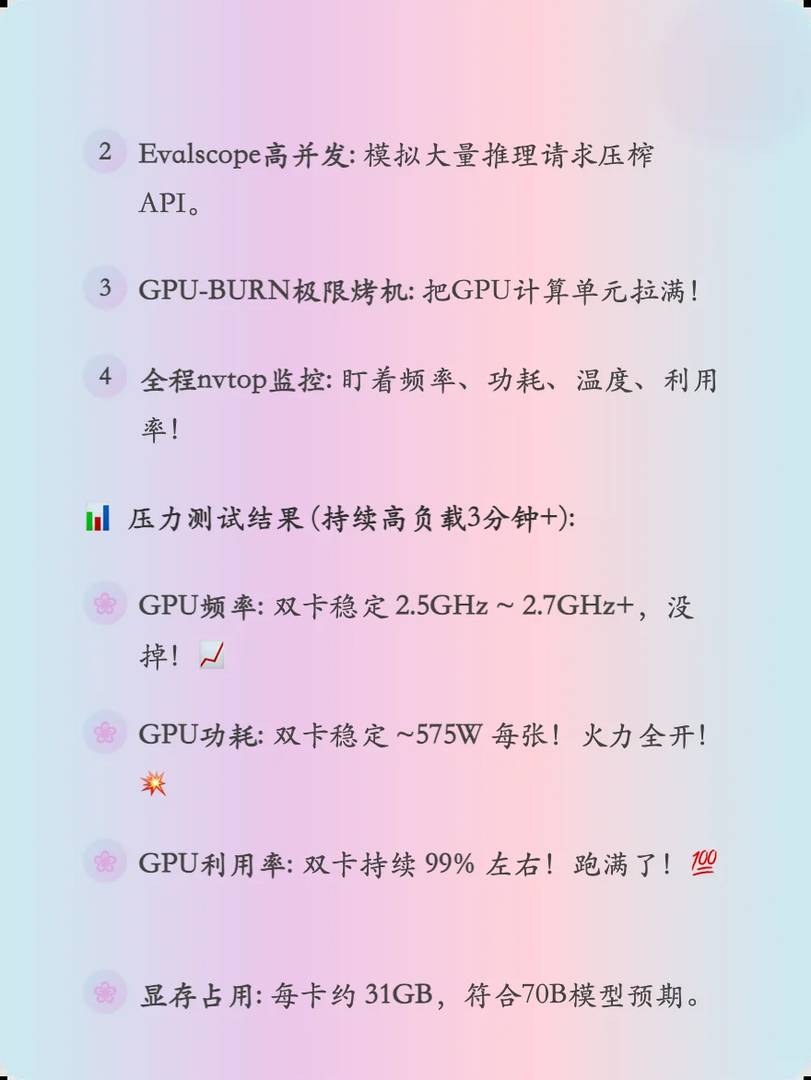

Ces résultats sont impressionnants, surtout la vitesse d’inference avec ce duo de RTX 5090. J’ai hâte de voir comment les limites de vitesse peuvent encore évoluer avec des optimisations logicielles. Les benchmarks montrent clairement l’avantage de cette configuration pour les tâches intensives en IA.

Ces résultats sont impressionnants, surtout la vitesse de traitement en parallèle. J’ai hâte de voir comment ces limites pourraient évoluer avec des mises à jour logicielles. Les benchmarks montrent clairement l’avantage d’un double GPU dans les charges de travail AI exigeantes.

Je suis ravi que vous ayez trouvé les résultats intéressants ! Vous avez tout à fait raison, les mises à jour logicielles ont un potentiel immense pour repousser encore les limites des performances. Personnellement, je suis curieux de voir comment les développeurs exploiteront cette architecture dans le futur. Merci pour votre enthousiasme et vos remarques pertinentes !

Ces résultats sont impressionnants, surtout la vitesse d’inference sur ce setup double GPU. Je me demande si ces limites de performance sont atteignables dans des environnements réels ou seulement en laboratoire. Les benchmarks pour PyTorch et TensorRT sont super intéressants, ça aide à savoir où optimiser mon propre projet.

Bonjour ! Ces performances sont effectivement proches de ce que vous pourriez observer dans des environnements réels, surtout pour des tâches bien optimisées comme celles-ci. Cependant, tout dépend de votre configuration matérielle et logicielle spécifique. Continuez à expérimenter avec les outils comme TensorRT, ils peuvent grandement aider à pousser les limites de vos projets. Merci pour votre intérêt et à bientôt sur le blog !

Wow, des tests sur la config double RTX 5090, ça donne vraiment envie de craquer pour ce setup monstre ! 😍 Les différences de perf entre les frameworks sont surprenantes, surtout sur les modèles lourds. Dommage que le scaling ne soit pas linéaire avec 2 GPU, mais ça reste impressionnant !