Wo die besten Evaluierungen und Vergleiche von Open-Source-Qwen3 zu finden sind

Worauf wartet jeder? Die Antwort ist einfach – es ist eine uneinnehmbare Kraft der Innovation und Fähigkeit...

⭐ Modellmerkmale: Tiefe Gedanken trifft Blitzgeschwindigkeit

🚀 Vorstellung von Qwen3, dem weltweit leistungsstärksten Open-Source-Modell, das DeepSeek R1 auf allen möglichen Gebieten übertrifft. Es markiert einen historischen Meilenstein als das erste inländische Modell, das eine umfassende Überlegenheit gegenüber R1 erreicht hat, während frühere Modelle nur dessen Leistung erreichen konnten.

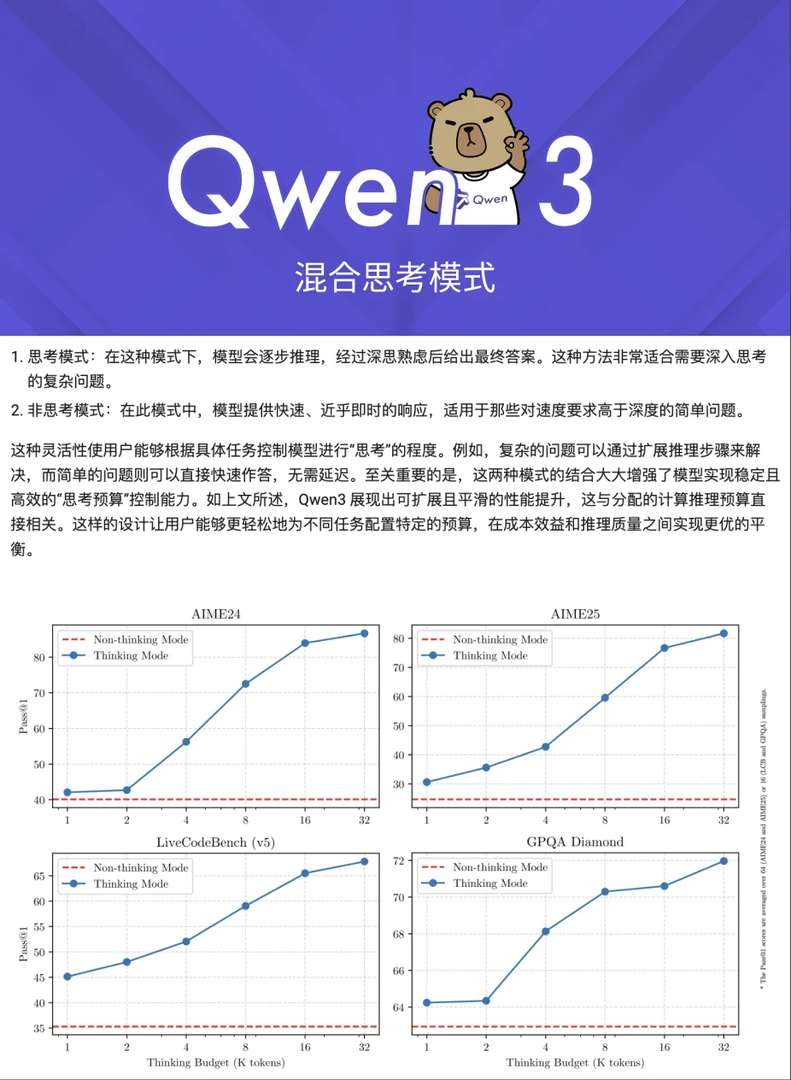

🤖 Qwen3 ist Chinas erstes hybrides Inferenzmodell, das tiefgehende Einblicke für komplexe Fragen 🧠 und sofortige Antworten für einfache Anfragen ⚡ liefert. Durch den nahtlosen Wechsel zwischen Modi wird die Intelligenz erhöht, während Rechenressourcen gespart werden – ein echter Gamechanger.

💡 Die Deploymentspezifikationen wurden revolutioniert. Das Flaggschiffmodell kann nun lokal mit nur 4 H20 GPUs 💻 deployiert werden, wodurch die Kosten um über 60 % im Vergleich zu R1 gesenkt werden.

🧑💻 Agentfähigkeiten haben neue Höhen erreicht, mit nativer Unterstützung des MCP-Protokolls, was die Codierfähigkeiten erheblich steigert. Inlandliche Agent-Werkzeuge freuen sich bereits auf seine Veröffentlichung.

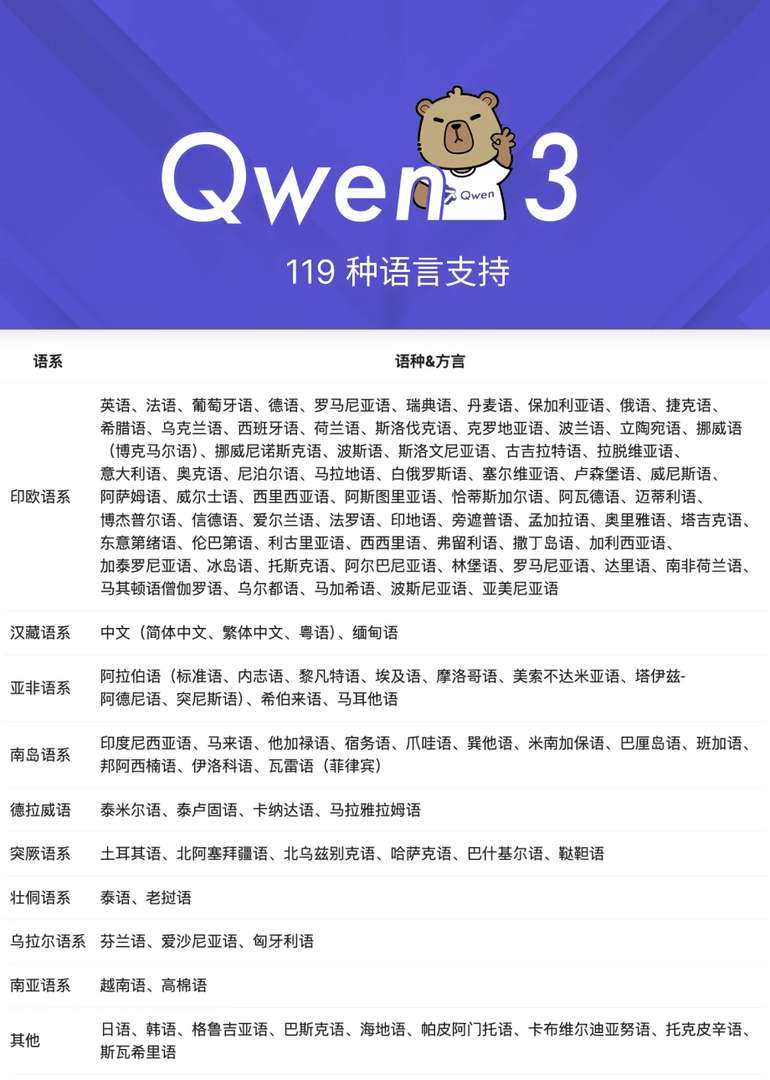

🌏 Mit Unterstützung von beeindruckend 119 Sprachen und Dialekten – einschließlich regionaler Mundarten wie Javanisch und Haitianisches Kreolisch – sorgt Qwen3 dafür, dass die AI-Zugänglichkeit keine Grenzen kennt.

📊 Trainiert auf einer atemberaubenden Menge von 36 Billionen Tokens, doppelt so viel wie bei Qwen2.5, umfasst das Trainingsdatenbestand nicht nur Webinhalte, sondern auch umfangreiche PDF-Materialien und synthetisierte Code-Schnipsel.

💰 Deployment ist noch nie kostengünstiger gewesen. Das Flaggschiffmodell benötigt nur 4 H20 GPUs, ein Drittel von dem, was R1 verlangt, was die Zugänglichkeit hochleistungsfähiger AI-Deployment für ein breiteres Publikum erleichtert.

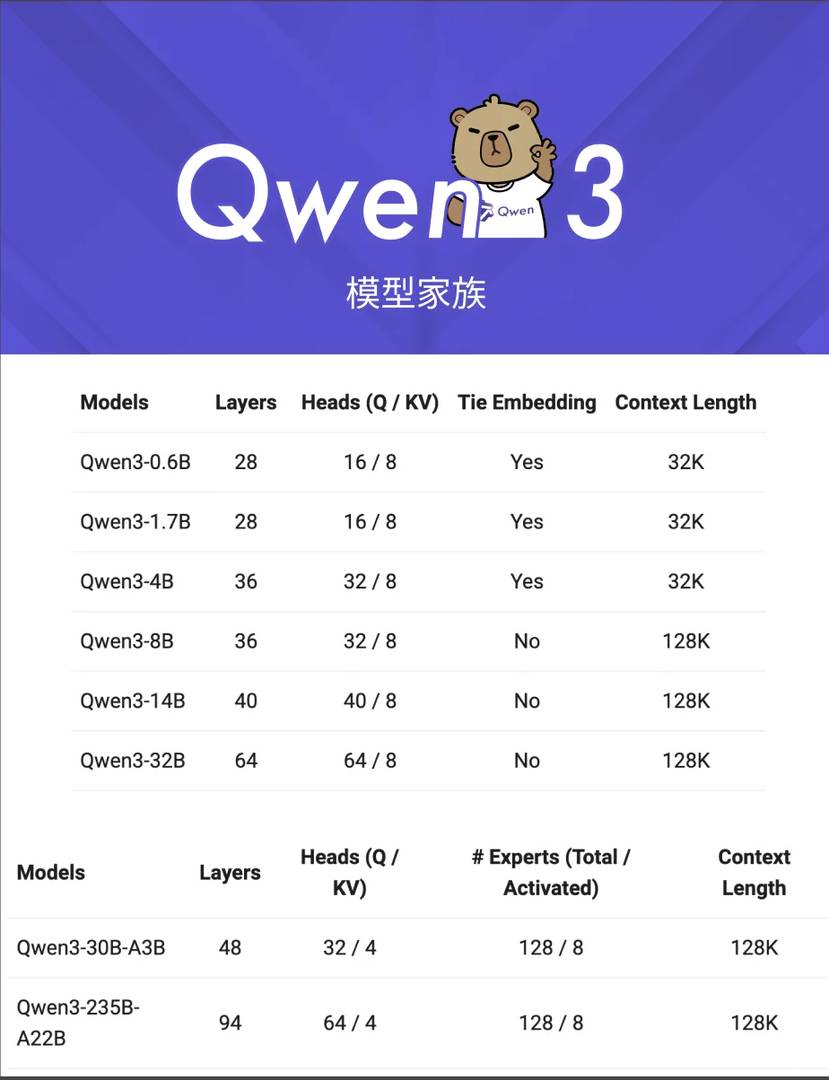

🏠 Die Qwen3-Familie kennen:

Insgesamt werden 8 Modelle als Open Source veröffentlicht, darunter 2 MoE-Modelle und 6 Dense-Modelle. - 2 MoE-Modelle: - Flaggschiffmodell Qwen3-235B-A22B, das nur 22B aktive Parameter hat, wodurch die Deploymentskosten auf ein Drittel von DeepSeek R1 gesenkt werden. - Miniaturmodell Qwen3-30B-A3B, das nur 3B aktive Parameter hat, bietet Leistung gleichwertig mit Qwen2.

5-32B, ideal für Consumer-GPU-Deployments. - 6 Dense-Modelle: 0.6B, 1.7B, 4B, 8B, 14B, 32B - Das leichtgewichtige 0.6B-Modell kann sogar auf Smartphones deployiert werden, was fortgeschrittene AI direkt in Ihre Tasche bringt.

Qwen3 ist hier, vollständig Open Source und bereit für Sie, es zu erkunden. Entdecken Sie es heute auf der offiziellen Website oder auf Github.

Das klingt wirklich beeindruckend! Ich habe noch nie von einem Open-Source-Modell mit solcher Leistung gehört. Hoffentlich wird es bald praktische Anwendungen geben, die wir alle ausprobieren können.

Das klingt wirklich beeindruckend! Ich bin gespannt, wie sich Qwen3 in der Praxis macht, vor allem was seine Innovationskraft angeht. Hoffentlich gibt es bald mehr praktische Beispiele und Benchmarks.