Google Ironwood TPU Release: Nächstes-Generation AI-Accelerator für Machine-Learning-Arbeitslasten

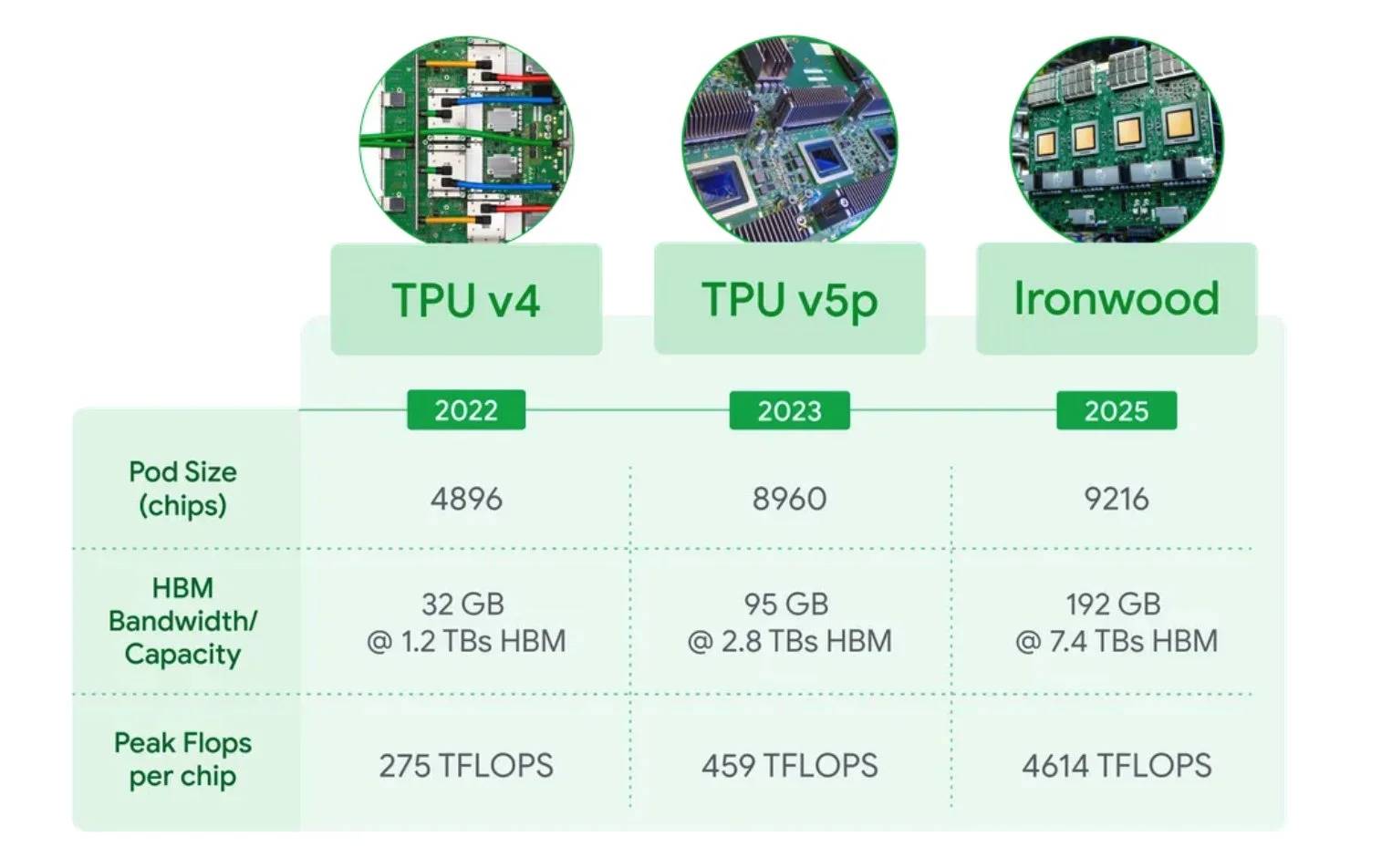

🌟 Google schlägt erneut zu! Bei der Google Cloud Next Konferenz 2025 hat Google sein siebentes Generation TPU – Ironwood, speziell für AI-Inference-Aufgaben entwickelt, vorgestellt, und seine Leistung ist absolut atemberaubend! Wie verrückt ist diese Aktualisierung? Lass uns reinhören! ⸻ 🎯 Wie leistungsstark ist Ironwood? • **Einzelchip-Leistung** Die Spitzenleistung erreicht eine beeindruckende 4.614 TFLOPs (10-mal schneller als TPU v5p!

), bringt AI-Inference-Geschwindigkeiten auf neue Höhen 🚀 • **Massives Speicherpotential** Jeder Chip verfügt über 192 GB HBM mit einer Bandbreite von 7,4 Tbps— 6-mal mehr Speicher und 4,5-mal mehr Bandbreite als die Vorgänger-Generation, was das Handhaben großer Datenmengen mühelos ermöglicht! • **Super-Cluster** Ein einzelner Pod enthält 9.216 Chips und liefert eine Gesamtleistung von 42,5 exaflops— 24-mal leistungsstärker als der weltweit größte Supercomputer! • **Doppelt so effizient** 2-mal energieeffizienter als Trillium und 30-mal besser als TPU v2! Energie sparen und umweltfreundlich bleiben!

🧠 Entwickelt für „Denkende“ KI Ironwood ist Googles erstes TPU speziell für AI-Inference konzipiert, ideal für das Ausführen von „denkenden“ KI wie großen Sprachmodellen (LLMs) und Mixture-of-Experts (MoE)-Modellen. Fortgeschrittene Modelle wie Gemini 2.5 und AlphaFold werden enorme Verbesserungen bei der Inference-Geschwindigkeit und -Kosten sehen!

⸻ ⚡ Schlüsselausbaupunkte • **Ultra-Schnelle Verbindung** Die Kommunikationsgeschwindigkeit zwischen den Chips erreicht 1,2 Tbps, ermöglicht eine nahtlose Zusammenarbeit zwischen mehreren Chips! • **Flüssigkeitskühlung** Unterstützt stabile Betriebsbedingungen für 9.216-Chip-Clusters ohne thermische Begrenzung! • **Software-Boost** Angetrieben durch Googles Pathways-System, verwaltet es mühelos Zehntausende von Chips—Entwicklererfahrung auf höchstem Niveau!

⸻ 🌐 Google vs. Nvidia? Mit Ironwood setzt Google kräftig in der AI-Hardware-Rennen an, direkt gegen Nvidia’s Blackwell B200 GPU antretend! Google hat auch vLLM-Unterstützung angekündigt, was es ermöglicht, GPU-optimierte PyTorch-Aufgaben reibungslos auf TPUs auszuführen—unübertroffene Kosten-Wirkungs-Verhältnisse!

⸻ 📅 Wann kannst du es nutzen? Ironwood ist für Ende 2025 geplant, mit Google Cloud-Benutzern als Ersten, die Zugang haben! Es wird auch in Googles AI-Hypercomputer integriert werden—Frühling für AI-Entwickler steht bevor!

⸻ 💬 Googles Ironwood ist wirklich nächste Generation! Denkst du, dass Google dieses Mal Nvidia besiegen kann? Teile deine Gedanken in den Kommentaren! 👇

Wow, 4,614 TFLOPs—that’s insane! I can’t wait to see how this will impact real-world applications like image recognition or natural language processing. Google really knows how to push the boundaries of what’s possible with AI hardware.

Danke für dein interessantes Feedback! Du hast völlig recht—4,614 TFLOPs ist wirklich beeindruckend. Ich freue mich auch darauf zu sehen, wie sich dieses Chipset in der Praxis für Aufgaben wie Bilderkennung oder Sprachverarbeitung auswirken wird. Google setzt hier wirklich neue Maßstäbe im AI-Hardware-Bereich. Vielen Dank für deine Begeisterung!

Wow, those numbers are insane! 4,614 TFLOPs is just on another level compared to previous generations. I can’t wait to see what kind of real-world applications this will unlock for machine learning. The memory bandwidth must be ridiculous too!